Authentizität und KI-Detektion

February 17, 2026

Methoden zur Überprüfung der Bildechtheit: Was heute funktioniert

SCHNELLES LESEN

<div class="hs-cta-embed hs-cta-simple-placeholder hs-cta-embed-116492913348"

style="max-width:100%; max-height:100%; width:170px;height:520px" data-hubspot-wrapper-cta-id="116492913348">

<a href="https://cta-eu1.hubspot.com/web-interactives/public/v1/track/redirect?encryptedPayload=AVxigLLzYHGtMYDgEXfYVUgSiXwccJLh5h3CwupigPP41t9C%2F%2FVGLQzQo6QfRZvkRixD3Gg8ORSe2kvWQLaQzNRj9oZIrDcCMVB4toZwj2GQNTwKFbP2xz0s6ZR7VIxerClVpKKlA56vLkY0Y6X9egfFZQbDbpD6n%2B2d3BdOYnLSFlg5cgNHHA%2FlABqhYebal4LFvJL9LUdJW%2B8x53h%2F7XQlGL9Y5bu%2BdF%2FA5MM6xEWx4QL3aw%3D%3D&webInteractiveContentId=116492913348&portalId=4144962" target="_blank" rel="noopener" crossorigin="anonymous">

<img alt="Do you know which laws apply to you?" loading="lazy" src="https://hubspot-no-cache-eu1-prod.s3.amazonaws.com/cta/default/4144962/interactive-116492913348.png" style="height: 100%; width: 100%; object-fit: fill"

onerror="this.style.display='none'" />

</a>

</div>

Teile diesen Artikel

Abonniere den Blog!

Ich abonniereDie Überprüfung der Echtheit von Bildern hat sich von einem technischen Nischenproblem zu einer praktischen Notwendigkeit entwickelt. KI-generierte und manipulierte Bilder kursieren heute neben echten Bildern, oft ohne Kontext, und Unternehmen werden zunehmend aufgefordert, zu rechtfertigen, warum einem bestimmten Bild überhaupt vertraut werden sollte.

Sichtprüfung und Metadaten allein reichen nicht aus, um Vertrauen aufzubauen. Um zu überprüfen, woher ein Bild stammt, ob es verändert wurde und wie es verwendet wurde, sind jetzt robustere und widerstandsfähigere Ansätze erforderlich.

Warum es so schwierig geworden ist, die Echtheit von Bildern zu überprüfen

Die Schwierigkeit der Überprüfung der Bildechtheit ist nicht auf einen einzigen technologischen Wandel zurückzuführen, sondern auf eine Kombination aus Umfang, Geschwindigkeit und Transformation.

Bilder werden in beispielloser Menge erstellt und geteilt. Sie werden sofort kopiert, komprimiert, beschnitten, neu formatiert und auf Plattformen erneut veröffentlicht, wobei routinemäßig Kontextinformationen entfernt werden. In dieser Umgebung versagen Verifizierungsmethoden, die für statische Dateien oder kontrollierte Workflows entwickelt wurden, schnell.

Authentizität ist auch nicht mehr nur eine einfache Frage von „echt versus falsch“. Was heute zählt, ist Fähigkeit, Herkunft, Integrität und Geschichte nachzuweisen. Wer hat das Bild erstellt? Unter welchen Bedingungen? Wurde es geändert und wenn ja, wie? Diese Fragen erfordern Beweise, keine Rückschlüsse.

Gleichzeitig macht regulatorischer, journalistischer und unternehmerischer Druck Authentizität zu einer betrieblichen Anforderung. Nachrichtenredaktionen müssen die Legitimität veröffentlichter Bilder verteidigen. Marken müssen schnell auf visuelle Fehlinformationen reagieren. Die Aufsichtsbehörden erwarten zunehmend Transparenz in Bezug auf synthetische und nichtsynthetische Inhalte. In allen Fällen muss die Echtheit nachweisbar sein und darf nicht vorausgesetzt werden.

Die wichtigsten Methoden zur Überprüfung der Bildechtheit erklärt

Eine Vielzahl von Methoden zur Überprüfung der Bildechtheit wird heute verwendet. Jede spielt eine Rolle, hat aber auch strukturelle Grenzen, die unter realen Bedingungen von Bedeutung sind.

a) Kontextuelle und investigative Methoden (von Menschen geleitet)

Kontextuelle und investigative Methoden stützen sich in erster Linie auf menschliche Analysen.

Umgekehrte Bildsuche wird häufig verwendet, um die Wiederverwendung von Bildern nachzuverfolgen, frühere Erscheinungsbilder zu identifizieren oder um zu erkennen, wenn Bilder aus dem Zusammenhang gerissen werden. Visuelle und forensische Inspektion konzentriert sich auf Hinweise wie inkonsistente Beleuchtung, unnatürliche Schatten, Klonartefakte oder Spleißkanten, die auf eine Manipulation hinweisen könnten.

Diese Ansätze sind für Journalismus, Forschung und Ermittlungen wertvoll. Sie sind jedoch manuell, subjektiv und schwer zu skalieren. Sie sind außerdem auf die Existenz vergleichbarer Referenzbilder und auf menschliche Interpretation angewiesen, was ihre Zuverlässigkeit unter Zeitdruck oder bei hoher Lautstärke einschränkt.

b) Dateibasierte und analytische Methoden (datenabhängig)

Dateibasierte Methoden analysieren Daten, die an das Bild selbst angehängt sind.

Analyse von Metadaten untersucht Informationen wie Aufnahmegerät, Zeitstempel, Geolokalisierung oder Bearbeitungssoftware. Fehlerstufenanalyse (ELA) und die Analyse von Komprimierungsartefakten suchen nach lokalisierten Inkonsistenzen, die möglicherweise eine Bearbeitung oder erneute Komprimierung erkennen lassen.

Diese Techniken können in kontrollierten Umgebungen effektiv sein, insbesondere wenn Originaldateien verfügbar sind. Sie sind jedoch von Natur aus fragil. Metadaten werden häufig von Plattformen und Workflows entfernt, und durch Komprimierung und Formatkonvertierung können analytische Signale ungültig werden. Sobald ein Bild im Umlauf ist, verlieren diese Methoden oft ihre Beweiskraft.

c) Automatisierte Erkennungsmethoden (probabilistisch)

Die automatische Erkennung basiert auf Modellen für maschinelles Lernen, die darauf trainiert sind, Muster zu erkennen, die mit KI-generierten oder manipulierten Bildern verknüpft sind.

Diese Systeme eignen sich für groß angelegte Screenings und Priorisierungen. Sie können dabei helfen, verdächtige Inhalte zu kennzeichnen oder abzuschätzen, ob ein Bild wahrscheinlich synthetisch ist.

Sie bleiben jedoch probabilistisch. Sie schließen auf Wahrscheinlichkeit, anstatt den Ursprung zu bestätigen. Ihre Leistung hängt von Trainingsdaten und Modellaktualisierungen ab, was sie anfällig für Modellabweichungen und kontradiktorische Anpassungen macht. Daher eignen sie sich nicht für Verifizierungen, bei denen es auf hohe Risiken ankommt, wenn Sicherheit gefragt ist.

d) Eingebettete Provenienzmethoden (überprüfbar)

Eingebettete Provenienzmethoden verfolgen einen grundlegend anderen Ansatz.

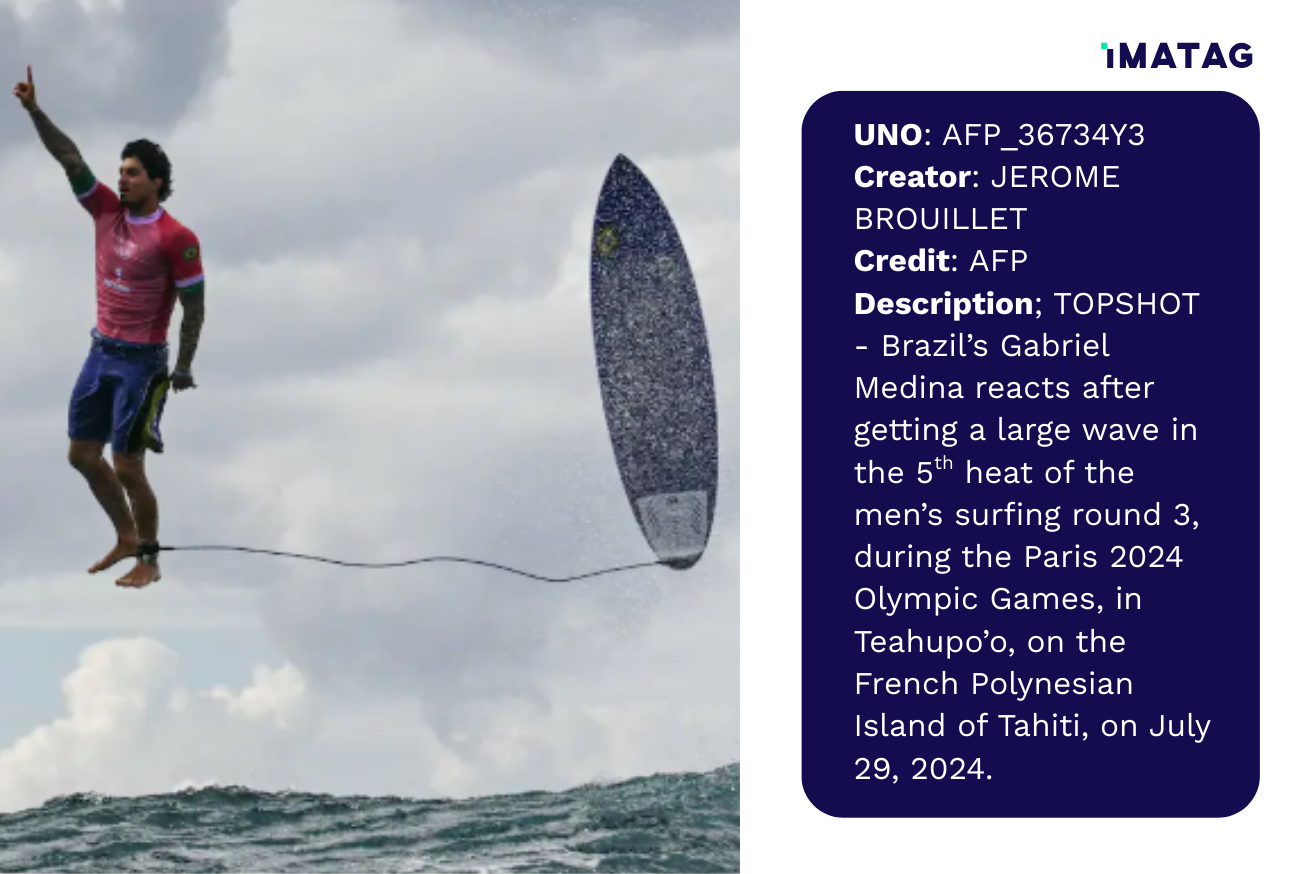

Digitales Wasserzeichen bettet Echtheitssignale direkt in die Pixel des Bildes ein, sodass der Inhalt selbst überprüfbare Informationen enthalten kann. Provenienz-Frameworks wie C2PA Erfassen Sie strukturierte Metadaten über Herkunft und Transformationen, um eine transparente Historie des Assets zu erstellen.

Metadaten bieten zwar umfangreiche Kontextinformationen, können aber während der normalen Dateiverwaltung entfernt oder geändert werden. Eingebettete Wasserzeichen umgehen diese Einschränkung, indem Echtheitssignale auf Pixelebene an das Bild gebunden werden. In fortgeschrittenen Implementierungen können Wasserzeichen auch als persistente Verbindung zu externen Herkunftsdaten dienen und so sicherstellen, dass die Verbindung zu den Originalinformationen wiederhergestellt werden kann, selbst wenn die Metadaten entfernt werden.

Diese Methoden sind eher für die Überprüfung im großen Maßstab als für die visuelle Inspektion konzipiert. Ihre Wirksamkeit hängt von Persistenz, Erkennbarkeit und der Fähigkeit ab, bei realen Transformationen eine zuverlässige Verbindung zwischen dem Bild und seinen Herkunftsdaten aufrechtzuerhalten.

Wenn die Bildüberprüfung fehlschlägt

Die meisten Methoden zur Überprüfung der Bildechtheit schlagen nicht zum Zeitpunkt der Erstellung fehl, sondern nachdem Bilder ihre ursprüngliche Umgebung verlassen haben.

Sobald Bilder auf Plattformen hochgeladen, komprimiert, beschnitten, per Screenshot aufgenommen oder zwischen Formaten konvertiert wurden, verschwinden viele Verifikationssignale. Metadaten können entfernt werden. Analytische Artefakte können verändert werden. Die Erkennungssicherheit kann unter nutzbare Schwellenwerte fallen.

In diesem Stadium ist nicht die Methode selbst ausschlaggebend, sondern wo sich das Echtheitssignal befindet. Einige Ansätze stützen sich auf Inferenz und schätzen die Authentizität auf der Grundlage von Mustern oder Wahrscheinlichkeiten. Andere hängen von den an die Datei angehängten Daten ab, die durch eine Routineverarbeitung entfernt werden können. Nur Signale, die direkt in das Bild eingebettet sind, bleiben zuverlässig erhalten, wenn der Inhalt geteilt und transformiert wird.

Wenn die Überprüfung fehlschlägt, sind die Konsequenzen konkret.

Rechtliches Risiko entsteht, wenn Unternehmen in Streitfällen, Ermittlungen oder regulatorischen Kontexten die Herkunft oder Integrität des Images nicht nachweisen können. Reputationsrisiko folgt, wenn authentische Bilder als falsch eingestuft werden oder wenn manipuliertes Bildmaterial unter dem Namen einer vertrauenswürdigen Marke verbreitet wird. Operationelles Risiko nimmt zu, da die Verifizierungsteams bei Krisen oder Fehlinformationsereignissen zu langsamen, manuellen Kontrollen gezwungen sind. Compliance-Risiko wächst, da neue KI- und Medienvorschriften stärkere Transparenz und Herkunftsgarantien erfordern.

Im Moment sind Beweise am dringendsten erforderlich, eine schwache Überprüfung hinterlässt nur Unsicherheit.

Wenn Methoden zur Bildauthentizität zusammenarbeiten müssen

Keine einzige Methode zur Überprüfung der Bildechtheit löst das Problem alleine.

Kontextanalyse sorgt für Verständnis. Erkennungswerkzeuge ermöglichen Skalierung. Provenienzstandards strukturieren detaillierte Informationen über Herkunft, Urheberschaft und Änderungsgeschichte. Die Herausforderung besteht darin, sicherzustellen, dass diese Schichten auch nach der Zirkulation der Bilder miteinander verbunden bleiben.

Metadaten und Herkunftsverzeichnisse können beschreiben, wie Inhalte erstellt wurden, einschließlich Aufnahmebedingungen, Bearbeitungshistorie oder sogar generativer Parameter. Wenn sich diese Informationen jedoch von der Bilddatei lösen, verringert sich ihre Beweiskraft.

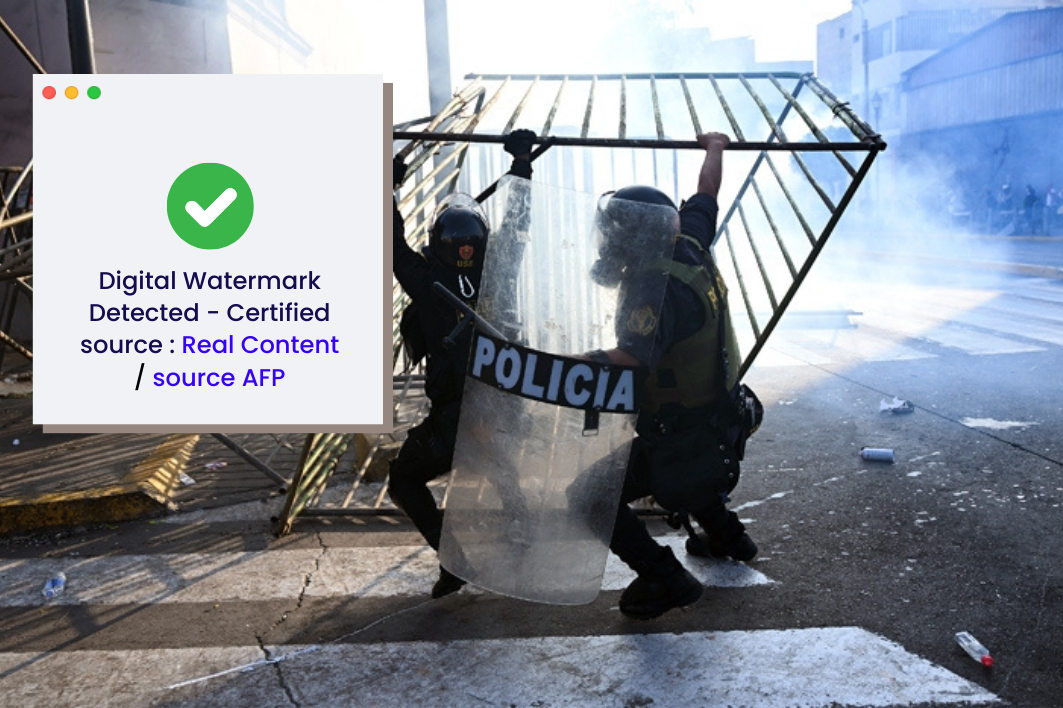

Hier spielen eingebettete Ansätze eine entscheidende Rolle. Digitale Wasserzeichen können Provenienz-Frameworks wie C2PA verankern auf Pixelebene, wodurch eine persistente Brücke zwischen dem Bild und den zugehörigen Metadaten entsteht. Anstatt Metadaten zu ersetzen, verstärkt das eingebettete Wasserzeichen diese und stellt sicher, dass Echtheitssignale die Komprimierung, gemeinsame Nutzung und Neuformatierung überstehen.

Einbettung der Überprüfung bei Erfassung oder Produktion verändert die Vertrauensgleichung grundlegend. Authentizität ist nicht mehr etwas, das nach der Zirkulation rekonstruiert wird, sie wird vom Bild selbst getragen, wohin es auch geht.

Vertrauen aufbauen, das die Zirkulation überlebt

In der Praxis sind Methoden zur Überprüfung der Bildechtheit nur so stark wie ihre schwächste Fehlerstelle. Bilder werden auf eine Weise bearbeitet, geteilt, transformiert und wiederverwendet, für die die meisten Verifizierungsansätze nie konzipiert wurden. In diesem Umfeld kann sich Vertrauen nicht allein auf Inspektion verlassen.

Aus diesem Grund bewegt sich das Bildökosystem allmählich weg von Erkennung und Interpretation und hin zu eingebetteter Authentizität und überprüfbarer Herkunft. Wenn das Bild selbst den Beweis liefert, ist eine Überprüfung auch nach Zirkulation, Komprimierung oder Wiederverwendung möglich.

Imatags Ansatz zur Authentizität basiert auf diesem Prinzip. Durch die Einbettung von robustem, unsichtbare Wasserzeichen direkt in visuellen Inhalten, Imatag sorgt dafür, dass Authentizität auch über Plattformen, Formate und Workflows hinweg erhalten bleibt. Herkunft und Überprüfung hängen nicht mehr von intakten Metadaten oder kontextueller Rekonstruktion ab, sondern bleiben an das Bild gebunden, egal, wohin es sich bewegt.

Willst du ein unsichtbares Wasserzeichen „sehen“?

Erfahren Sie mehr über die IMATAG-Lösung zum Einfügen unsichtbarer Wasserzeichen in Ihre visuellen Inhalte.

Eine Demo buchenDiese Artikel könnten Sie auch interessieren

Authentizität und KI-Detektion

January 16, 2026

CES 2026: Was der KI-Hype an der Echtheit von Bildern immer noch vermisst

Authentizität und KI-Detektion

December 16, 2025

Erkennung von KI-generierten Bildern: Warum robuste Wasserzeichenstandards wichtig sind

Authentizität und KI-Detektion

July 8, 2025