Authenticité & Détection d'IA

Droit d'auteur

September 28, 2023

SynthID de Google DeepMind et l'impératif d'un filigrane complet

LECTURE RAPIDE

<div class="hs-cta-embed hs-cta-simple-placeholder hs-cta-embed-148431706223"

style="largeur maximale : 100 % ; hauteur maximale : 100 % ; largeur : 170 pixels ; hauteur : 570,703125 px » data-hubspot-wrapper-cta-id="148431706223">

<a href="https://cta-service-cms2.hubspot.com/web-interactives/public/v1/track/redirect?encryptedPayload=AVxigLKZHPCM48e7X6Jh6q%2FHTayvEM6WFXfVUmMYKCsyKh6XhLJMOeRHroWJs5vbBioch6K9q89LSnwwa2bf6Sb5nIcpHFPOGAibLFi3svmRrJe7VaMIpyjDPkg8hlnboqQwh6XFjf9TwglgS3gP7TNnYNdKOe%2BBvODCQwbBD83bW%2BFzBT68L%2FZXs5DsAHw2ApqKbjCguOaYatyR0irsRV8C8dpsROUMP5%2BnXw4oa2wfbGIrUuFXeec0oe9CovRhkg%3D%3D&webInteractiveContentId=148431706223&portalId=4144962" target="_blank" rel="noopener" crossorigin="anonymous">

<img alt="Histoire du filigrane numérique Téléchargez notre infographie « La saga du filigrane numérique invisible : un voyage dans le temps » loading="lazy » src= » https://no-cache.hubspot.com/cta/default/4144962/interactive-148431706223.png "style="height : 100 % ; width : 100 % ; object-fit : fill »

onerror="this.style.display='aucun' »

</a>

</div>

Partagez cet article

Abonnez-vous au blog !

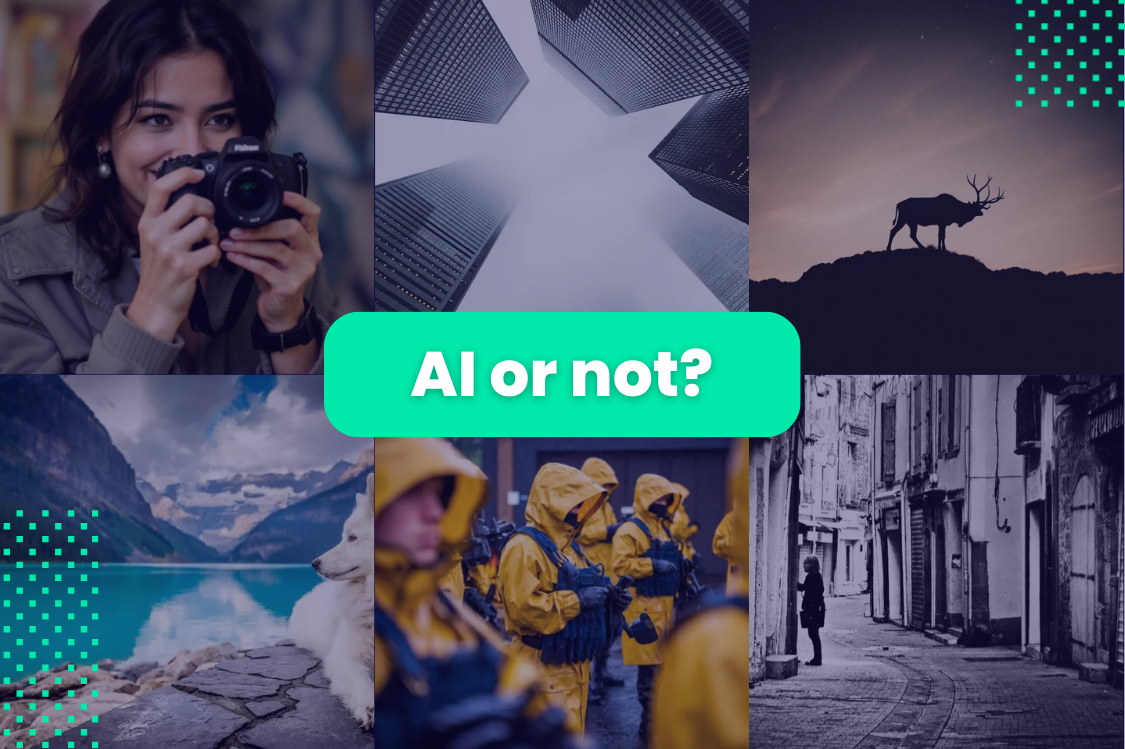

Je m'abonnePlongez dans le domaine de l'authenticité des images en analysant l'intégration de la technologie SynthID de Google DeepMind pour identifier les images générées. Explorez les complexités de cette innovation et ses lacunes potentielles sur la question plus large de la garantie d'un contenu d'image fiable.

Dans le cadre d'un développement significatif dans le monde de l'intelligence artificielle et des technologies génératives, DeepMind de Google a récemment annoncé son intention d'intégrer la technologie de filigrane invisible de SynthID dans ses systèmes d'IA. Bien que cette initiative mette en lumière la technique essentielle du filigrane invisible, elle soulève également d'importantes questions quant aux implications plus larges et à la nécessité de filigraner des images authentiques. L'initiative de DeepMind est louable, mais elle souligne l'importance du filigrane du contenu original, car tous les logiciels d'IA générative ne peuvent pas suivre les traces de Google. Cette évolution s'inscrit dans la longue histoire du filigrane invisible, initialement conçu pour résoudre les problèmes de violation du droit d'auteur, et aujourd'hui motivé par deux facteurs clés : l'érosion de la confiance du public dans les images et la demande croissante des gouvernements, y compris la Maison Blanche, pour que les logiciels d'IA générative puissent filigraner leur contenu. De plus, les systèmes d'IA eux-mêmes s'appuient sur le contenu et doivent faire la distinction entre les données authentiques et les données générées.

L'évolution du filigrane invisible : lutter contre les violations du droit d'auteur

Le concept du filigrane invisible, une technique qui permet d'intégrer des marqueurs cachés dans du contenu numérique, a une longue histoire. Il est apparu en réponse aux défis posés par la numérisation rapide des médias dans les années 1990. À l'origine, son objectif principal était de lutter contre les problèmes de violation du droit d'auteur. La possibilité d'intégrer des filigranes imperceptibles dans les actifs numériques a permis aux titulaires de droits d'auteur de retracer et de prouver la propriété, fournissant ainsi un outil puissant pour protéger leur propriété intellectuelle.

La crise de l'authenticité des images : un dilemme croissant

Nous vivons aujourd'hui à une époque marquée par des doutes quant à l'authenticité des images numériques. La prolifération d'outils alimentés par l'IA et de modèles génératifs, illustrée par Deepfake technologie, a laissé le public dans l'incertitude quant à la véracité des médias visuels. En conséquence, les particuliers et les organisations sont devenus de plus en plus prudents lorsqu'il s'agit d'accepter les images numériques à leur juste valeur nominale, craignant la manipulation et la désinformation.

L'appel au filigrane dans l'IA générative : une réponse à la tromperie

Reconnaissant l'incertitude croissante qui entoure l'imagerie numérique, les gouvernements et les organisations prennent des mesures proactives. La Maison Blanche, dans le cadre de ses efforts visant à gérer les risques liés à l'IA, a appelé les principales entreprises d'IA à apposer un filigrane sur leur contenu génératif. Cette étape vise à apporter transparence et authenticité, en permettant au public d'identifier le contenu provenant de systèmes d'IA génératifs et en réduisant risque de tromperie.

L'appétit insatiable de l'IA pour les données : le défi de l'authenticité

Au-delà des préoccupations du public, il est urgent que les systèmes d'IA eux-mêmes fassent la distinction entre le contenu authentique et le contenu généré. Les modèles d'IA, y compris ceux développés par DeepMind, s'appuient sur de vastes ensembles de données pour la formation. Ces ensembles de données sont souvent composés d'un mélange de données réelles et synthétiques. Il est essentiel de s'assurer que les systèmes d'IA peuvent différencier efficacement ces types de données pour maintenir leur précision et leur fiabilité.

L'initiative de DeepMind : promouvoir la transparence

La décision de DeepMind intégrer la technologie de filigrane invisible de SynthID à ses systèmes d'IA représente une étape importante dans la résolution de la crise d'authenticité de l'imagerie numérique. En ajoutant un filigrane à son contenu génératif, DeepMind vise à établir une distinction claire entre les images générées par l'IA et les images réelles. Cela renforce non seulement la confiance du public, mais contribue également à l'effort plus large visant à lutter contre la prolifération de contenus trompeurs en ligne.

Des implications plus larges : un appel au filigrane pour le contenu authentique

Bien que l'initiative de DeepMind soit louable, elle souligne également l'importance de filigraner le contenu original et authentique. Tous les logiciels d'IA générative ne choisissent peut-être pas de suivre l'exemple de Google, laissant ainsi une lacune dans le paysage du filigrane. Pour y remédier, il est essentiel d'envisager de filigraner des images authentiques afin de préserver la confiance et l'intégrité des médias visuels. En fait, des photos de presse, qui sont déjà courantes filigranés pour suivre leurs publications en ligne, peuvent être facilement identifiés comme authentiques.

De plus, le volume d'images générées est sur le point de croître de façon exponentielle. Pour mettre les choses en perspective, L'IA a généré plus d'images à ce jour que l'humanité n'en a créées en des centaines d'années. Ce contraste de volume saisissant entre les images générées et les images authentiques souligne le besoin crucial de solutions de filigrane robustes pour maintenir la confiance, d'autant plus que le nombre de photos d'actualité prises chaque année reste relativement stable.

Naviguer dans les eaux complexes du filigrane

La décision de DeepMind d'adopter la technologie de filigrane invisible de SynthID souligne la nécessité d'une approche multidimensionnelle pour résoudre la crise d'authenticité de l'imagerie numérique. Alors que l'IA générative devient de plus en plus omniprésente et accessible, la technologie de filigrane offre un moyen crucial de faire la distinction entre le réel et le généré. Bien que l'initiative de DeepMind représente une avancée louable, elle met l'accent sur le besoin plus large de filigraner des images authentiques. Cette intégration marque un moment charnière dans la poursuite de l'histoire du filigrane invisible, soulignant sa pertinence durable à une époque où la confiance et l'authenticité sont des préoccupations primordiales. En fin de compte, il ouvre la voie à un avenir où l'authenticité du contenu numérique sera préservée et où le public pourra naviguer dans le paysage numérique en toute confiance.

Vous voulez « voir » un filigrane invisible ?

En savoir plus sur la solution d'IMATAG pour insérer des filigranes invisibles dans votre contenu visuel.

Réservez une démoCes articles peuvent également vous intéresser

Authenticité & Détection d'IA

January 16, 2026

CES 2026 : ce que l’engouement autour de l’IA oublie encore sur l’authenticité des images

Authenticité & Détection d'IA

December 16, 2025

Détecter les images générées par l’IA : pourquoi des standards robustes de watermarking sont essentiels

Authenticité & Détection d'IA

July 8, 2025